Amazon aproxima Trainium3 do modelo da Nvidia em nova geração de servidores para IA

- Cyber Security Brazil

- 8 de dez. de 2025

- 3 min de leitura

A Amazon apresentou recentemente seu novo sistema Trainium3 UltraServer, e a semelhança com os racks Nvidia GB200 e GB300 NVL72 chamou atenção imediata da indústria. À medida que a corrida pela computação de IA entra em seu quarto ano, a infraestrutura usada pelos grandes provedores começa a convergir para arquiteturas e padrões visivelmente semelhantes, reforçando a tendência de modularização e compatibilidade entre plataformas.

A AWS já opera milhares de racks Nvidia NVL72 e, diante da aparência quase idêntica entre os UltraServers e os sistemas da rival, especialistas acreditam que parte considerável da arquitetura física pode ser compartilhada. A própria Amazon confirmou que o Trainium4, já anunciado, será compatível com o mesmo chassi MGX usado pelas GPUs da Nvidia uma integração que sugere um ecossistema cada vez mais padronizado.

Do ponto de vista de escala, essa padronização faz sentido. A AWS, como maior provedora de nuvem do mundo, reduz custos e complexidade ao operar infraestruturas modulares e intercambiáveis, em vez de manter racks exclusivos para cada geração de chips. Essa estratégia está alinhada aos princípios promovidos por iniciativas como o Open Compute Project (OCP), do qual Amazon e Meta são fundadoras. Em outubro, Nvidia contribuiu com os designs MGX para o OCP, enquanto AMD e Meta apresentaram um novo rack de largura dupla baseado na arquitetura Helios.

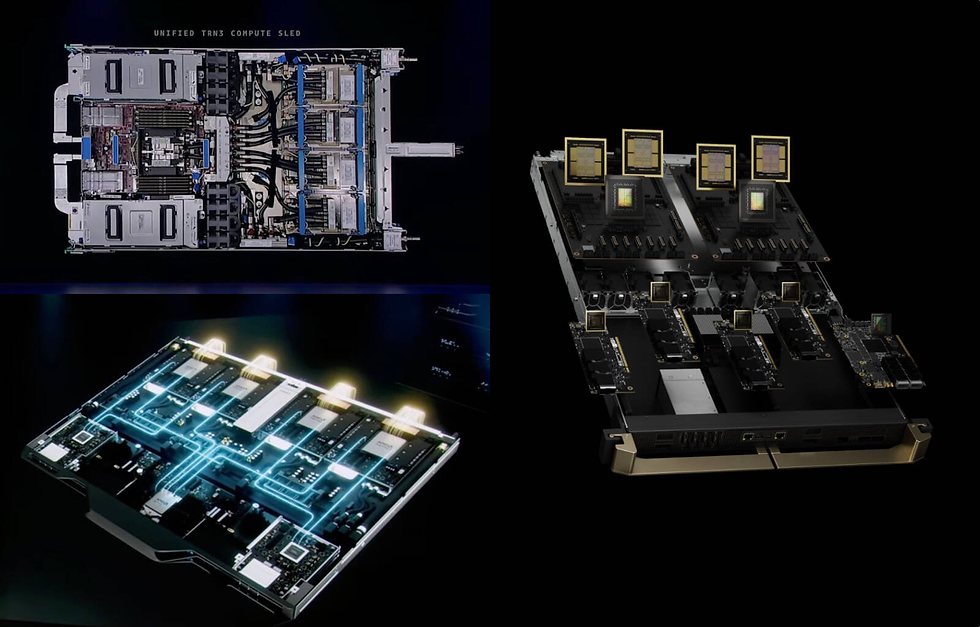

Além da aparência semelhante, o design computacional também converge. No re:Invent, Peter DeSantis mostrou a nova lâmina computacional Trainium3, equipada com um CPU Graviton, quatro aceleradores Trainium3 e duas unidades Nitro. Até então, os sistemas Trainium utilizavam processadores Intel, mas a mudança aproxima o design da AWS das arquiteturas vistas em racks da AMD que combinam quatro GPUs MI400 com um único processador Venice e smartNICs e dos racks GB300 da Nvidia, que utilizam dois CPUs Grace.

A ascensão dos fabrics scale-up

Cada rack Trainium3 UltraServer reúne 36 lâminas computacionais, totalizando 144 aceleradores, interconectados via a nova tecnologia NeuronSwitch. Embora a AWS ainda não tenha divulgado detalhes da topologia, a configuração lembra a arquitetura dos sistemas Nvidia e AMD, que utilizam dezenas de switches para agregar a capacidade computacional e de memória em um único cluster lógico.

Esses fabrics de alta velocidade permitem que 72, 144 ou mais chips funcionem como um único superacelerador. A diferença está nos protocolos: a AWS usa NeuronSwitch; a AMD encapsula o protocolo UALink sobre Ethernet; e a Nvidia opera com NVLink e NVSwitch. Curiosamente, a AWS já anunciou que seus próximos chips Trainium4 irão adotar tanto UALink quanto NVLink Fusion, indicando que o NeuronSwitch pode ser transitório.

Historicamente, até o Trainium2, a AWS usava malhas 2D e 3D Torus para interconectar aceleradores. Mas segundo Nafea Bshara, cofundador da Annapurna Labs, os workloads atuais especialmente inferência em larga escala exigem baixa latência e acesso amplo à memória agregada, o que favorece fabrics com switches. “A geração de tokens na etapa de decode exige largura e latência muito baixa. O switch nos permite escalar desse jeito”, explicou.

O preço da flexibilidade, no entanto, é a complexidade: meshes não precisam de switches, enquanto fabrics precisam e ainda não vimos designs escalando muito além de 144 aceleradores por cluster.

Google: o ponto fora da curva

Enquanto Amazon, Nvidia e AMD convergem para arquiteturas baseadas em switches, o Google segue uma rota distinta. Seus clusters TPU 7ª geração (Ironwood) utilizam malhas 2D e 3D Torus capazes de escalar até 9.216 TPUs em um único domínio computacional algo muito superior à escala observada em designs baseados em switches.

O segredo está no uso agressivo de interconexões ópticas, tecnologia que Nvidia, AMD e Amazon evitam devido ao maior consumo energético. O Google mitiga esse impacto usando optical circuit switching (OCS), uma espécie de “mesa telefônica óptica automatizada”, que permite reorganizar clusters inteiro de TPUs removendo nós defeituosos e adicionando novos com poucos comandos.

Com a AWS adotando fabrics com switches, o Google se torna um dos últimos grandes provedores a manter arquiteturas baseadas em torus para treinamento e inferência de IA em escala massiva.

Via - TR